Jde o AI agenty, které jsou navržené tak, aby podporovaly důvěryhodné a bezpečné interakce s AI.

Je umělá inteligence novou investiční bublinou?

Fungují v různých podobách – mohou pracovat jako asistenty AI, jež podporují uživatele při úkolech, jako jsou kontrola, monitorování a analýza obsahu nebo jako poloautonomní, či dokonce plně autonomní agenty, které jsou schopné formulovat a vykonávat různé akce nebo přesměrovávat či blokovat operace, aby byly v souladu s předem definovanými cíli.

Podle Gartneru budou tyto strážní agenty do roku 2030 představovat nejméně 10 až 15 % trhu s agentní AI.

Podle jejího průzkumu z května tohoto roku 2025 už 28 % respondentů nasadilo více AI agentů ve své infrastruktuře.

Polovina respondentů pak uvedla, že tuto technologii zkoumají a experimentují s ní, zatímco dalších 17 % respondentů tvrdí, že tak neučinili, ale plánují tuto technologii nasadit nejpozději do konce roku 2026.

Aby se u těchto AI agentů udržela dostatečná bezpečnost, je zapotřebí vytvořit metody automatizované kontroly důvěryhodnosti, rizik a bezpečnosti – a to je úkol právě pro strážné agenty.

„Agentní AI povede k nežádoucím výsledkům, pokud se nebude dostatečně kontrolovat odpovídajícími opatřeními,“ tvrdí Avivah Litan, analytička Gartneru.

Podle ní zmíněné strážní agenty využívají široké spektrum schopností agentní AI a zároveň disponují řadou deterministických hodnocení založených na AI, které slouží pro dohled a správu celé škály schopností běžných AI agentů, a to při vyvážení rozhodování v reálném čase a řízení rizik.

Hrozby od agentní AI

Vzhledem k tomu, že použití AI agentů stále roste, existuje několik kategorií hrozeb, které na ně mají dopad včetně manipulace se vstupy či otrávení dat, kdy agenty spoléhají na kompromitovaná nebo nesprávně interpretovaná data. Jak příklad analytici uvádějí:

• Únos a zneužití přihlašovacích údajů, vedoucí k neoprávněné kontrole a krádeži dat.

• AI agenty interagující s falešnými nebo zločinnými webovými stránkami a zdroji, které mohou vést k akcím neslučitelným se zájmy provozovatele těchto agentů.

• Odchylky fungování AI agentů nebo neúmyslné chování v důsledku vnitřních nedostatků nebo vnějších spouštěčů, které mohou poškodit reputaci provozovatele AI agentů a narušit provoz organizace.

„Stoupající vliv AI agentů vyžaduje posun kontroly nad rámec tradičního lidského dohledu,“ vysvětluje Litan.

Vzhledem k tomu, že se podniky postupně přesouvají ke komplexním systémům s více agenty, které komunikují ve srovnání s lidmi závratnou rychlostí, sami uživatelé už nestačí držet krok s potenciálem chyb a škodlivých aktivit AI komponent.

Tato rostoucí hrozba podtrhuje naléhavou potřebu mít strážné agenty, jež organizacím dokážou poskytnout automatizovaný dohled, kontrolu a zabezpečení pro agentní AI.

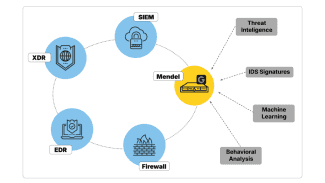

Podle analytiků by se firmy měly zaměřit na tři hlavní typy použití strážných agentů:

- Recenzenti: Identifikace a kontrola výstupů a obsahu generovaných prostřednictvím AI z hlediska přesnosti a přijatelného použití.

- Monitorovací agenty: Sledování a trasování akcí agentní AI pro následné kroky ze strany lidí nebo AI.

- Ochránci: Úprava nebo blokování akcí a oprávnění agentní AI pomocí automatizovaných akcí během provozu. Strážní agenty budou spravovat interakce a anomálie bez ohledu na typ použití. Jde o klíčový pilíř jejich integrace, protože lze předpokládat, že do roku 2028 bude 70 % aplikací AI používat multiagentní systémy.

Computertrends si můžete objednat i jako klasický časopis. Je jediným odborným magazínem na českém a slovenském trhu zaměreným na profesionály v oblasti informačních a komunikačních technologií (ICT). Díky silnému zázemí přináší aktuální zpravodajství, analýzy, komentáře a přehledy nejnovejších technologií dříve a na vyšší odborné úrovni, než ostatní periodika na tuzemském trhu.

Obsah Computertrends je určen odborníkům a manažerům z firem a institucí, kteří se podílejí na rozhodovacím procesu při nákupu ICT technologií. Jednotlivá čísla si můžete objednat i v digitální podobě.